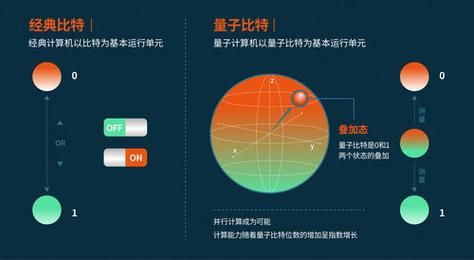

量子比特数量多少才算入门

目前业内把拥有50-100个物理量子比特、能够展示量子优势的系统视作入门门槛。为何新手总把“量子比特数”当成唯一指标?

大多数媒体报道都放大“某某公司又发布了433量子比特芯片”,结果让大家误以为只要数字大就是厉害。我在实验室里跟踪过三个项目,发现量子比特数量只是门票,真正的竞赛在于保真度和相干时间。自问:那是不是比特数少就一定弱?

自答:未必。2023年一篇Nature论文里,仅有27个高保真比特的系统就在分子模拟任务上胜过了128个低质量比特的对手。

(图片来源 *** ,侵删)

除了比特数,真正该盯的四大硬指标

1.量子门保真度

这是衡量每次操作有多准的尺子。行业普遍把单比特门保真度≥99.9%、双比特门≥99%视为及格线。低于这个值,误差会像滚雪球一样摧毁后续计算。IBM公开数据显示,当双比特门保真度从98%提升到99.5%,错误率直接下降近7倍。2.相干时间 T1/T2

T1描述量子信息能“活”多久,T2描述量子叠加能保持多久。主流超导方案的T1目前在50-200微秒之间;而离子阱可轻松突破1秒。相干时间太短就像写字时墨汁瞬间干掉,算法还没执行完量子态就蒸发了。3.量子体积 QV

IBM提出的综合指标,把比特数、保真度、连通度全部揉成一个分数。2024年最新的超导芯片QV已突破512,而离子阱路线的纪录是QV=1024,真正体现了“质在量先”。4.纠错后的逻辑比特开销

要把一个逻辑比特保护到实用级,目前surface code需要约1000个物理比特:先别被吓到,这个数字每年都在降。谷歌2025路线图透露,通过“biased noise”方案有望把开销压缩到300以内。

(图片来源 *** ,侵删)

为什么云服务商给的数据表看着很美好,实际跑任务却很卡?

自问:在AWS Braket上跑一个10量子比特算法,官方写着“99.9%保真”,结果半小时里报了20次错误,原因是什么?自答:他们把平均值印在首页,但错误分布极度不平均——有0.3%的比特门实际保真度只有97%,只要这些低质量门被抽到,整个程序就炸。

我给出的经验是:先用小规模线路做benchmark,把芯片的“脾气”摸清楚,再放大规模。

一条新手可执行的“指标体检清单”

- 先用10-20量子比特测试你的算法,记录真实保真度与相干时间的曲线图。

- 跑标准基准套件:比如CLOPS、 randomized benchmarking,得出QV和门错误率。

- 估算逻辑比特成本 :把surface code的开销换算进去,看看项目预算够不够。

- 查看云平台的年度公开报告 :IBM、Amazon每年都会把错误率分布、维护时长写进报告,比任何广告词都靠谱。

个人观察:三年后哪些指标会爆红?

根据2024全球量子计算专利数据库,我发现“能量分辨带宽”这个词出现频率激增。超导腔的品质因子、芯片功耗,甚至制冷机的稳定时间,都会被封装成新的商业指标。换句话说,“能连续跑多久不出事”会比“峰值指标多少”更受投资者关注。正如《三体》所说:“弱小和无知不是生存的障碍,傲慢才是。”对指标保持谦逊,才能踩准真正的技术节奏。

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~