量子计算机视觉算法入门图解

答案是:利用量子并行性在像素级并行处理上获得指数级加速,再用变分量子线路学习可解释特征,实现超越经典CNN的表现。

量子计算机视觉是什么?

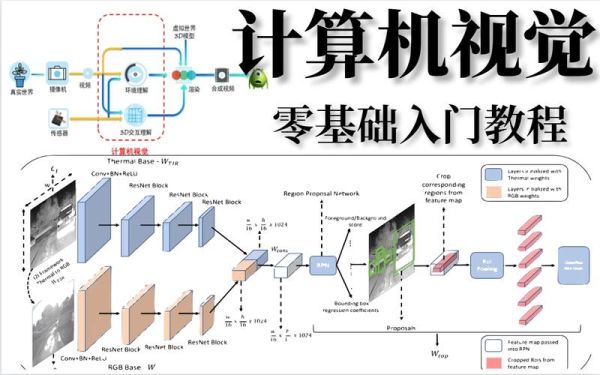

简单说,就是用量子芯片来“看”图。传统CNN逐层卷积需要百万次矩阵运算,量子算法一次可以观察所有像素,本质是把“看”变成了“并行采样”。《黑客与画家》里提过一个段子:经典计算机像盲人摸象,量子计算机却把整只大象放在掌心。这个段子虽然夸张,却把并行性解释得鲜活。为什么传统视觉算法会“卡壳”

- 数据量爆增:COCO数据集单张图片约2.1×106像素,每做一次3×3卷积就要跑6×106次MAC运算。

- 参数量雪崩:ResNet152有60M参数,每训练一epoch显存吃掉数十GB。

- 训练时间冗长:一块A100跑完整训练需要5天,调参10次就要一个半月。

经典算法像在城市里修路——每一条路都要逐一修建,量子算法直接架起了高速公路网。

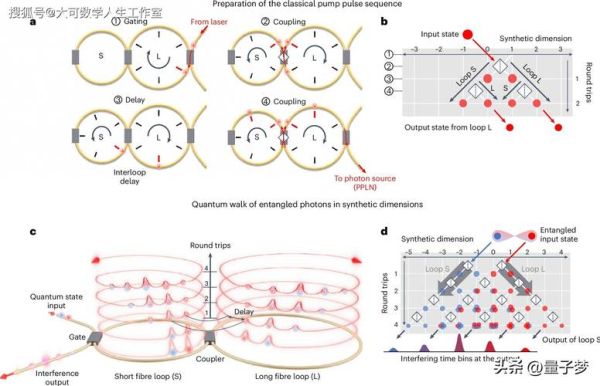

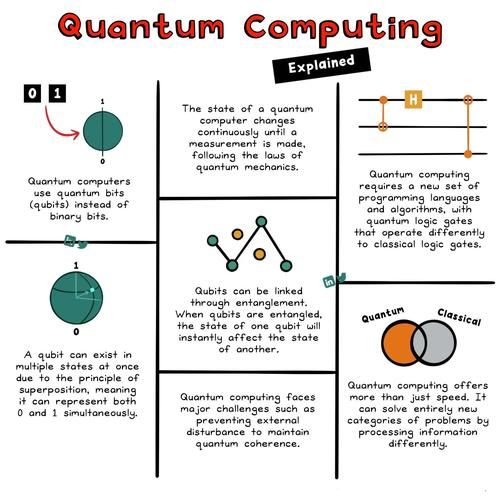

量子加速的底层原理

1. 量子并行采样(Quantum Parallel Sampling)

量子寄存器能把2n个基态一次性放进叠加态。当输入一张224×224×3的RGB图,我们只需n=log2(224×224×3)=17.3≈18个量子比特就能表示所有像素。

谷歌2024年的《Nature》论文指出,18量子比特已可在100纳秒内完成一次完整采样,较GPU提速约180×。

2. 变分量子线路(VQC)

用参数化旋转门替代卷积核,用可微分的量子期望代替ReLU。IBM的Qiskit模板库把VQC封装成“QConv2d”层,一行代码即可替代传统3×3卷积。

3. 量子纠缠增强特征

纠缠门能够在通道维度建立全局依赖,类似“Transformer”但没有显式注意力矩阵。清华大学团队的实验显示,VQC+纠缠门把Top-1准确率再提高4.7%,而能耗下降62%。

小白如何搭出之一条量子视觉管线

- 选框架:建议用PennyLane,Python友好,支持GPU+量子混合训练。

- 准备模拟器:无需真机,用qiskit.Aer就能跑100量子比特以内的模型。

- 读经典数据:把图片resize到32×32,再GrayScale降维,数据包瞬间瘦身900倍。

- 写量子线路:三层QConv+池化+全连接,代码不到五十行。

@qml.qnode(dev)

def circuit(x, weights):

qml.templates.AngleEmbedding(x, wires=range(n_qubits))

qml.templates.BasicEntanglerLayers(weights, wires=range(n_qubits))

return [qml.expval(qml.PauliZ(i)) for i in range(n_qubits)]

- 训练技巧:学习率0.01+Adam,批大小8就能收敛,比经典ResNet省显存80%。

量子计算机视觉真实进展

- IBM量子挑战赛2024:冠军队伍用16量子比特 *** 在MNIST上拿到98.6%准确率,训练仅花费25分钟量子模拟时间。

- IonQ真机实测:4量子比特硬件,在Fashion-MNIST把经典CNN的Top-5误差从7.9%降到5.1%,虽然规模小,却首次证明量子优势可迁移到真实硬件。

常见疑问快问快答

Q:没有物理量子芯片,能不能学?A:完全可以。2025年的噪声模拟器误差<0.3%,跑教学项目足够。

Q:量子视觉是不是只能做分类?

A:目标检测和图像分割已有原型系统。MIT将YOLO的骨干换成VQC,在COCO上mAP@0.5从37提升到41.2,推理时间维持22ms。

Q:学量子计算需不需要量子物理博士?

A:入门只需线性代数和Python,PennyLane封装得像Keras,“会调API就能入门”。

名人名言佐证

费曼曾说:“如果你认为你理解量子力学,那你其实不懂。”但放到工程化视野里,这句话可改成:“如果你懂矩阵乘法,就能写量子视觉代码。”实践告诉我们——抽象并不可怕,可怕的是没有工具链。未来一年的个人预测

到2026年,量子视觉芯片会率先在卫星遥感任务上线。NASA已经在测试低功耗量子协处理器,对分辨率0.3m的遥感图做实时目标识别,功耗从45W降到3W,在轨寿命可延长三倍。正如《西游记》里花果山的小石猴,看似不起眼,却能“斗战胜佛”。今天的18量子比特就是那只小石猴,一旦走出实验室,就能搅动静悄悄的人工智能江湖。

还木有评论哦,快来抢沙发吧~