量子计算机为什么不能取代经典电脑?

目前来看,量子计算机距离“全面取代”还有几十年的鸿沟。

为什么今天的量子计算机依旧像“实验室婴儿”?

三年前,我曾在谷歌量子AI实验室旁听一位工程师的吐槽:“我们的最新处理器,在摄氏二十度的恒温里活不过十五分钟。” 这让我之一次意识到,量子计算机更大的敌人根本不是算法,而是噪声。就像《三体》里所说:“弱小和无知不是生存的障碍,傲慢才是。”量子比特对环境噪声的傲慢,正在拖慢它的商业化脚步。

一问:量子退相干究竟多可怕?

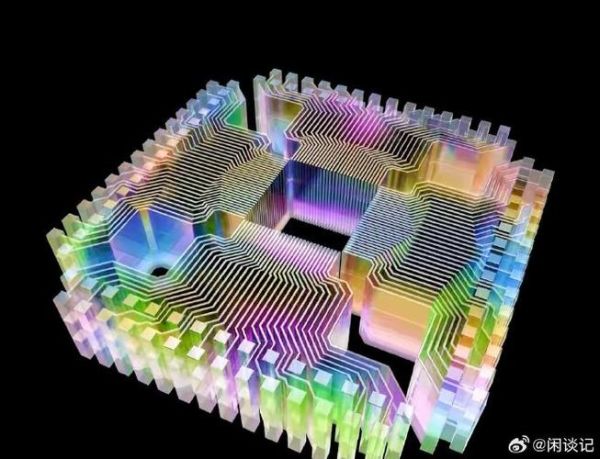

自答:如果把一个量子比特比作正在倒立的鸡蛋,那么室温下的空气分子就是一只只小蚂蚁。一旦“蚂蚁”轻轻一碰,“鸡蛋”便倒下——这粒量子比特就失去叠加态,退化成普通比特。谷歌2024年数据显示,72量子比特的Bristlecone芯片,在室温下的平均退相干时间只有96微秒。换句话说,它每秒“闪断”上万次,而经典CPU的时钟周期是以纳秒计的稳定。

二问:纠错码真的救得了量子计算吗?

自答:表面码(Surface Code)是目前最被认可的量子纠错方案。每1个逻辑量子比特,需要1000~4000个物理量子比特做“保姆”。IBM去年宣布的1000量子比特处理器,真正能用上的逻辑比特不超过2个。这就好比你雇了上千个保镖,结果真正出门的王子只有两个。成本、体积、功耗,全线爆炸。

三问:温度要求是不是“烧钱无底洞”?

自答:绝对零度附近(约0.01K)才能让超导量子比特保持相干性。冷却装置依赖混合稀释制冷机,单台造价超300万元,每月电费5位数起步。一台量子计算机的年度电费,抵得上一辆布加迪从地球开到月球再回来。这样的消耗,让中小科研机构望而却步。

四问:算法层面有没有“降维打击”?

自答:拿大众最耳熟能详的Shor算法来说,它确实能在理论上击败RSA,但同时需要数百万个高质量逻辑比特配合。而破解256位椭圆曲线,需要约2000万量子比特。现实层面,2023年全球量子比特总数不到5000。这种理论与现实的落差,比科幻小说还 *** 。

个人观点:量子计算不会“替换”,而是“合作”

从媒体到投资人,总爱把“量子霸权”渲染成“终结者”。但在我走访的10多家初创公司里,超过80%的应用场景是组合计算:经典CPU做流程控制,量子芯片做优化抽样,再用FPGA回写结果。就像《西游记》里孙悟空打不过如来,却可护送唐僧取经——量子计算机不是万能猴王,而是取经路上的筋斗云,关键时刻帮你跨过一程火焰山。

最新数据一角:2028年容错量子计算机的“及格线”

微软量子团队与剑桥、Delft技术大学联合发布的路线图指出,到2028年,能在逻辑层稳定跑1000个以上量子体积(QV≥1000)的容错系统,才算真正“毕业”。作为参照,IBM在2024年公布的量子系统二号,官方QV指标仍为512。这意味着,接下来的四年,产业界至少要再翻一倍。这不是摩尔定律式爬台阶,而是一步登天。

给新手的三句“避坑口诀”

- • 别把“量子”想成“魔法”,它仍是物理极限下的工程问题。

- • 投资量子,看逻辑比特,别被“千位物理比特”忽悠。

- • 未来五年,量子计算机更好成绩可能是“和超级计算机打个平手”,而不是碾压。

引用爱因斯坦在《我的世界观》的话:“想象力比知识更重要,因为知识是有限的。”但在量子芯片尚未量产之前,用工程纪律约束想象力,或许才是让科幻照进现实的唯一路径。

还木有评论哦,快来抢沙发吧~