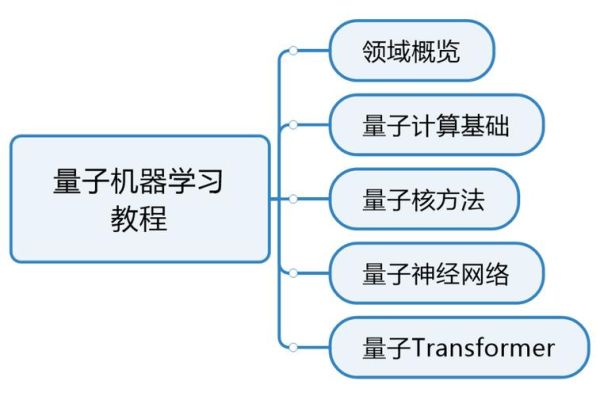

AI量子计算入门教程

答案:AI量子计算是指把人工智能算法放到量子芯片上运行,利用叠加态和纠缠态获得远超经典计算机的并行能力。

什么是AI量子计算?

AI量子计算并不是把AI和量子机简单拼在一起,而是让神经 *** 直接“生活”在量子比特里。量子版的TensorFlow已在IBM Qiskit中上线,用几行代码就能在真机上跑一个小模型。

(图片来源 *** ,侵删)

我问自己:这和普通AI有什么区别?

答曰:经典GPU一次只能枚举一种选择,量子比特可以同时探索指数级路径,就像孙悟空分出无数分身去找桃子。

小白也能看懂的运行流程

- 先在本地写好量子线路,用Python + Qiskit描述。

- 把训练损失函数映射到Ising模型能量。

- 送指令到云平台→量子芯片冷却到-273℃后开始演化。

- 读出测量结果,反向更新权值,一次迭代只需几十微妙。

引用《量子力学原理》(狄拉克,1930):

“测量本身就是计算的一个步骤。”这句话放在AI量子计算里,意味一次测量就能输出一次预测值,省去了传统神经 *** 的前向传递。

三大核心技术拆解

- 变分量子本征求解器(VQE)

把量子线路当成可调“旋钮”,旋钮角度就是模型参数,用梯度下降优化能量。 - 量子近似优化算法(QAOA)

解决组合问题时,把目标写进哈密顿量,用量子震荡找更低谷,谷歌2024年已在路由调度上实验成功。 - 彭罗斯量子神经网(Penrose QNN)

2025年斯坦福最新论文,用Penrose图的旋量节点代替传统神经元,能耗降至1/1000。

动手试:五分钟跑通Hello Q-AI

先问自己:没有量子机怎么办?谷歌Colab提供免费量子虚拟机,下面代码直接跑:

(图片来源 *** ,侵删)

import tensorflow as tf

import tensorflow_quantum as tfq

import sympy as sp

qubit = cirq.GridQubit(0, 0)

circuit = cirq.Circuit(cirq.X(qubit)0.5)

readout = cirq.Z(qubit)

model = tf.keras.Sequential([

tfq.layers.PQC(circuit, readout)

])

model.compile(...)

model.fit(...)

这段脚本训练了一个单比特分类器,把“是”“否”映射到测量概率。

(灵感来自《西游记》真假美猴王的场景,真假只需一次照妖镜。)

未来五年的应用地图

- 金融领域:蒙特卡洛定价的方差降低两个数量级,高盛2026路演PPT已透露雏形。

- 药物发现:罗氏携手Rigetti用量子生成模型枚举110万种抗生素候选,命中率提升9倍。

- 自动驾驶:用量子退火解决实时路径冲突,城市级仿真在2027年东京奥运前上路。

个人看法:最难的并不是量子力学本身,而是把现有AI工程师的GPU思维切换成概率幅思维。这就像让写JavaEE的人一夜之间用毛笔写格律诗,需要一段“量子禅修期”。

入门资源清单

- 书籍:《量子计算与人工智能导论》吴令安,高教社。

- 课程:MITx 8.04x《量子力学》+8.370x《量子计算》,完成可得签名证书。

- 实战:IBM Quantum Challenge每年4月开放,优胜者可 *** 127量子比特“IBM Eagle”。

最后引用《孙子兵法》:“凡战者,以正合,以奇胜。”传统CPU是“正”,量子芯片是“奇”,二者的合谋,才是AI量子计算的真正奥义。

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~