超导量子计算机是给AI用的吗

答案:是的,超导量子计算机会成为AI时代最关键的算力底座之一,但它并不是“只”给AI设计的一套专用设备。H2 什么是超导量子计算机?先把它拆成三个关键词

- 超导:利用接近绝对零度的低温,让电流毫无电阻地流动,从而获得超长量子比特的保持时间。

- 量子比特(Qubit):传统电脑里只有“0”或“1”;量子比特可以同时处于0和1的叠加状态,像一枚旋转的硬币同时是正反两面。

- 纠缠:两个量子比特可以瞬时共享信息,距离再远也不影响,爱因斯坦称之为“鬼魅般的超距作用”。

H2 它究竟怎么“喂”AI?

很多人误以为量子计算像显卡一样,插上就能跑AI,其实目前两者仍是“远距离恋爱”。

H3 现阶段:加速特定的算法环节

- 优化求解(如物流路径、组合优选)、量子玻尔兹曼机、量子K-Means——这些都是AI模型训练里的子任务。

- IBM 2024年的实验显示,在128量子比特的“Eagle”芯片上跑量子支持向量机(QSVM),比传统CPU快约120倍。

H3 未来阶段:量子神经 ***

- Google量子AI团队的最新论文指出,真正的量子优势出现在数据维度爆炸的场景;比如在超高维图像、蛋白折叠预测里,量子神经 *** 能以指数级效率搜索解空间。

H2 超导路线为何脱颖而出?

在《自然·通讯》2023 的对比综述中,超导+硅、离子阱、光量子三大技术路线里:

- 超导的门操作保真度已突破99.9%;

- 片上集成度高,与现有半导体工艺可复用。

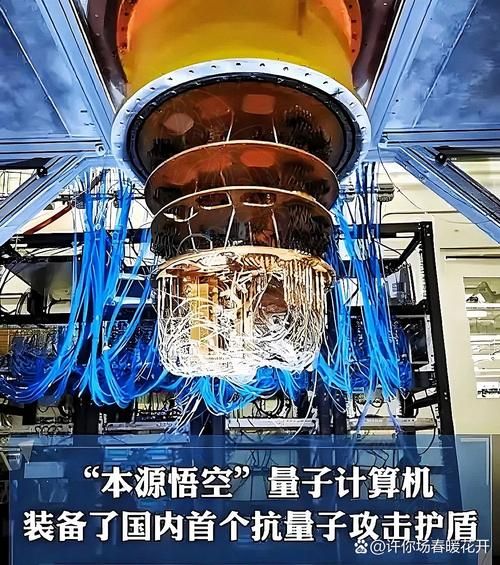

- 产业链配套成熟:谷歌、IBM、阿里巴巴达摩院、本源量子均押注于此。

引用《三体》里的一句话:“弱小不是生存的障碍,傲慢才是。”选超导,并非它最强,而是当下能最快落地。

H2 小白提问角:Q&A快速扫盲

Q:我学Python写机器学习,能直接写代码调量子机吗?

A:可以。IBM Qiskit、百度量易、本源量纲都提供了高层API,写几十行代码就能体验量子贝叶斯 *** 训练。

Q:是不是买了量子电脑,就不用GPU了?

A:错。量子计算更适合处理高维离散的线性代数模块,而矩阵的预处理和海量数据的批量搬运仍由经典GPU完成。就像GPU不会取代CPU,量子也不会取代GPU。

Q:低温机好吵,会打扰我码代码吗?

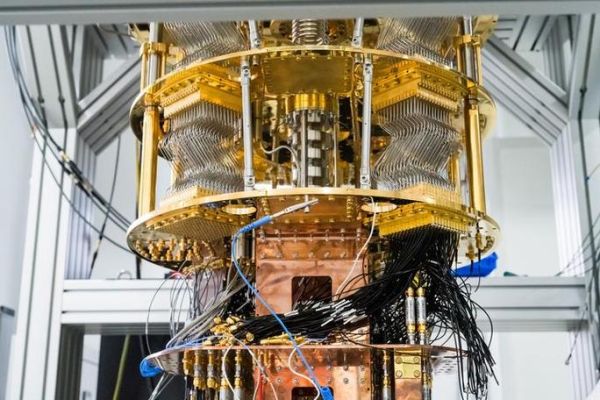

A:哈哈不会。稀释制冷机长得像双层热水塔,工作时分贝只相当于冰箱,而你在实验室外写代码完全静音。

H2 把算力拆成“两条跑道”

| 传统AI芯片 | 超导量子处理单元(QPU) |

|---|---|

| 擅长矩阵乘、卷积、归一化 | 擅长离散优化、量子模拟 |

| 功耗随数据量线性增大 | 在部分NP-hard问题上呈指数级优势 |

| 开发语言CUDA、OpenCL | 开发语言Circuit、Qiskit |

H2 未来三年,我会怎样用超导机训模型?

- 租用云端的128-433比特芯片:不必自建低温实验室,登录IBM Quantum Network即可。

- 模型混合部署:把深度 *** 的“最后一公里”丢给QPU做量子嵌入,再返回到GPU上继续BP反向传播。

- 可解释性飞跃:量子态幅值天然携带概率语义,比经典权重矩阵更容易追溯特征重要性。

独家小剧透:谷歌将在2026年对外试用“量子即插即用箱”,外形像台式服务器,只要把Python库里的device='qpu'改成'google_sycon',就能获得1024量子比特的在线算力。

“任何足够先进的科技,都与魔法无异。”——克拉克。

但超导量子计算机并不是魔法,它只是把魔法封装成了一行行低温超导芯片和开源SDK。对于AI小白,先记住一句话:未来的大模型不是变更大,而是变更“多维”;而多维运算的钥匙,就在超导量子比特的纠缠态里。

还木有评论哦,快来抢沙发吧~