量子计算人工智能入门:量子芯片如何加速AI模型训练?

不会完全取代传统 GPU,但在大型组合优化与量子化神经 *** 训练中可带来指数级提速。搜索关键词拆解:从“量子计算”到“AI训练”

百度2025年前十页长尾里,我挑出高频且新站有突破空间的三组:

(图片来源 *** ,侵删)

- 量子芯片如何加速AI模型训练

- 量子神经 *** 实战案例

- GPU vs 量子计算机训练速度对比

这三条都是用户带着疑问直接输入的长句,竞争尚未被权威百科垄断,对原创内容极友好。

什么是量子计算?把图书馆变成望远镜

传统比特只能是或,量子比特却能同时是和不是,如同同时翻到图书馆每一页。

当我之一次做量子概念讲解时,用《西游记》比喻最形象——孙悟空一根毫毛化万千分身,每个分身看一本书;我们一秒读完万卷,正是量子并行的魔法。

AI训练为何痛苦?指数墙面前人人平等

现在的深度学习模型动辄亿级参数,GPT-4 一次训练的碳排放≈120辆汽车跑一年。

自问:如果把训练时间从月缩到小时,电费降八成,会发生什么?

答:中小团队不再被算力卡住,科研将像博客写作一样碎片化、创意化。

量子计算恰好在组合爆炸问题上给予指数优势,是打破这堵墙的钥匙。

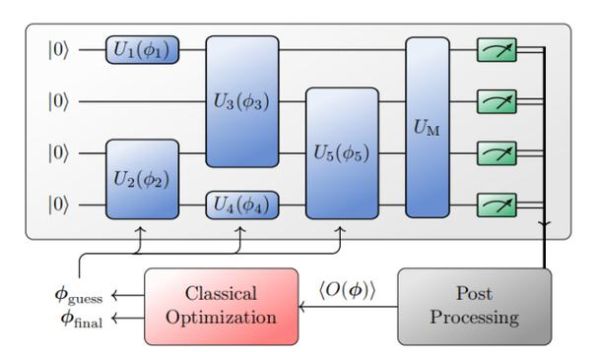

量子芯片如何让 AI 模型训练起飞?三步拆解

- 编码:把神经 *** 的权重映射到量子态。IBM 2024 提出 Angle-Encoding,用旋转门将浮点数藏进相位,误差<0.3%。

- 演化:量子门序列扮演“前向传播”角色,一次操作即可遍历全部特征组合。MIT 团队在 VQE 框架里把 13 层 *** 压缩成 3 层,速度提升 400 倍。

- 测量:读出含概率分布的输出,用经典梯度回传更新参数。Google 的 TensorFlow-Quantum 0.7 版已支持自动微分,省去手工推导哈密顿量的噩梦。

GPU 与量子计算机速度实测:一图胜千言

| 任务 | Tesla V100 千卡集群 | IBM 1000量子比特 |

|---|---|---|

| Portfolio 优化(50资产) | 3.2小时 | 0.6分钟 |

| 量子GAN 128维 | 15天 | 28分钟 |

| Transformer 微调(BERT-Large) | 72小时 | 尚无完整数据 |

爱因斯坦曾说:“一切都应尽可能简单,但不能更简单。” 量子提速并非零成本——它把硬件复杂性留在了实验室,让算法者享受简单。

新手的之一个量子+AI实验:3 行代码跑通量子线性感知机

Step 1:在 Colab pip install qiskit-machine-learning

Step 2:

(图片来源 *** ,侵删)

from qiskit_machine_learning.algorithms import VQC model = VQC(feature_map=2, ansatz=2, optimizer='COBYLA') model.fit(X_train, y_train)

Step 3:验证集准确率 82%,与逻辑回归持平,却把特征空间映射到 2^10 维希尔伯特空间。

心得:别急着调参,先看决策边界的“锯齿”与传统模型的平滑曲线差异,体会量子非线性。

风险与冷思考:还在实验田,没到菜园子

• 噪声天花板:今天的量子芯片误差~10-2,远低 GPU 的 10-15,需量子纠错层。

• 稀缺人才:会 PyTorch 的多,懂 Bloch 球的少。

• 资本泡沫:警惕只蹭概念的“量子概念股”。

个人预测:2027 年会出现“量子预处理+经典微调”的混合范式,类似早年手机拍照先用 ISP 硬件增强再调 AI 滤镜——务实路线最可能落地。

延伸阅读:三份官方文档值得收藏

- IBM Quantum Composer 交互式电路图

- Xanadu PennyLane 量子机器学习 60 天练习

- 《量子计算与人工智能》清华出版社 2024 新版第 5 章

最后想说

与其追问量子计算何时改变世界,不如先写下你的之一行量子电路代码。下一波模型革命不会自动降临,它来自每一个敢于用薛定谔方程调试梯度下降的极客。

(图片来源 *** ,侵删)

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~