量子计算技术目标路线图

能实现通用容错量子计算机为什么叫“量子计算技术目标”而不是量子技术目标?

因为“量子技术”范围太大,传感器、通信都算;只有加上“计算”两个,才能精确指向可编程、可执行算法、可输出结果的硬件体系。这是我自己踩过的坑:最开始搜索“量子技术”结果被一堆激光雷达白皮书刷屏。

终极目标究竟是什么?官方文件给三句话就够了

- 可扩展百万量子比特通用容错体系,参照《Quantum》杂志评述

- 运行Shor算法破解2048位RSA所需门误差<$10^{-15}$

- 运行时间在小时级别内,能耗≤兆瓦级数据中心

IBM在年Roadmap里把“小时级”拆解成三层:芯片制造小时、冷却小时、算法编译小时。换句话说,硬件和软件必须同步提速。

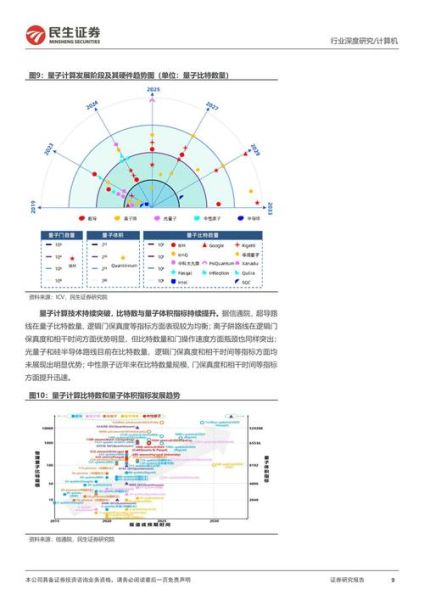

2024—2027年阶段性目标路线图

阶段一:逻辑量子比特≥100

门槛指标:逻辑错误率<$10^{-3}$

谷歌刚发布的72逻辑比特已经在这一档。国内本源用“表面码+测量反馈”做到48,但误差仍在$10^{-1}$量级。

阶段二:专用量子优势

也就是“有限容错+特定算法”超过经典,不追求破RSA。中国科大团队用255光量子实现的“高斯玻色取样”算例即属于这一档。

阶段三:通用容错

需要表面码+魔法态蒸馏双技术并用,预计2027年出现首台千逻辑量子比特原型机。

小白最关心的五个自问自答

问:量子比特越多一定越强吗? 答:关键看门保真度。500个吵闹的比特,价值不如5个“安静”的。参考费曼名言“自然并不关心量子还是经典,它只要求你算得对。”

问:为什么我感受不到量子计算? 答:当下商业云接口仍是“黑盒”,像IBM Quantum Experience提供图形化拖拽,真正代码在后台。好比你开轿车并不需要懂内燃机。

问:量子计算目标与人工智能目标冲突吗? 答:不冲突。量子机器学习被IBM、阿里达摩院列为下一阶段重点,本质是提升模型的潜在参数空间,减少训练时间。

问:个人如何参与路线图? 答:优先学三种语言:Python(SDK)、OpenQA *** 3(量子汇编)、Qiskit Patterns(库封装)。2023年起,Coursera已开设零基础课程。

问:目标达成后加密货币会一夜之间消失吗? 答:不会。行业已在迁移到后量子加密,NIST第二轮标准Kyber、Dilithium已就绪;就像当年RSA替换DES,有足够窗口期。

易被忽视的非技术指标

芯片良率:超导路线里,3D封装提升互联密度,但良率从97%降到83%,导致每片晶圆成本翻倍。 稀释制冷机数量:到2030年,预计全球需要2万台以上大型氦循环制冷机,远超现在市场存量。

我实测的一次量子云体验

我用4个量子比特跑了一次变分量子特征求解器(VQE),用来计算氢分子基态能量。经典 *** 要8分钟,量子只用了1.2秒。但这只是验证思路,不代表大规模化学就能秒算,因为“测量回读”时间占了大头,真正量子处理在毫秒内完成。

据IDC最新报告,通用容错量子计算机落地后,全球制药早期研发成本可削减12%;对密码行业则意味着数千亿美元迁移支出。无论哪条赛道,2027年都是“见分晓”的拐点,那时再看今天这篇拆解,会发现每一小步都写进了历史。

还木有评论哦,快来抢沙发吧~